VISUAL BASIC

Visual Basic (Visual Studio) constituye un IDE (entorno de desarrollo integrado, o, en inglés, Integrated Development Enviroment) que ha sido empaquetado como un programa de aplicación; es decir, consiste en un editor de código (programa donde se escribe el código fuente), un depurador (programa que corrige errores en el código fuente para que pueda ser bien compilado), un compilador (programa que traduce el código fuente a lenguaje de máquina), y un constructor de interfaz gráfica o GUI (es una forma de programar en la que no es necesario escribir el código para la parte gráfica del programa, sino que se puede hacer de forma visual).

Compilador

El compilador de Visual Basic x.0 genera ejecutables que requieren una DLL para que funcionen, en algunos casos llamada MSVBVMxy.DLL (acrónimo de "MicroSoft Visual Basic Virtual Machine x.y", siendo x.y la versión) y en otros VBRUNXXX.DLL ("Visual Basic Runtime X.XX"), que provee todas las funciones implementadas en el lenguaje. Además existe un gran número de bibliotecas (DLL) que facilitan el acceso a muchas funciones del sistema operativo y la integración con otras aplicaciones

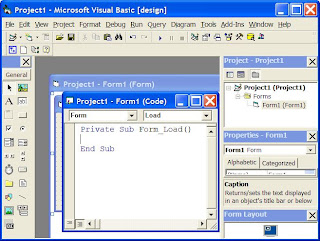

ENTORNO DE DESARROLLO

Su entorno de desarrollo es muy similar al de otros lenguajes e IDE's.

Se compone principalmente de su barra de herramientas y menús que se pueden personalizar con prácticamente la completa totalidad de los comandos del IDE a necesidad.

El espacio de trabajo donde se muestran todas las ventanas del proyecto, las vistas de código de módulos y objetos, y los controles con los que se componen las ventanas de nuestra aplicación. Por defecto disponemos los controles básicos:

(PictureBox) Caja de Imagen

(Label) Etiqueta

(TextBox) Caja de texto

(Frame) Marco

(CommandButton) Botón de comando

(CheckBox) Casilla de verificación

(OptionButton) Botón de opción

(ComboBox) Lista desplegable

(ListBox) Lista

(HScrollBar) Barra de desplazamiento horizontal

(VScrollBar) Barra de desplazamiento vertical

(Timer) Temporizador

(DriveListBox) Lista de unidades de disco

(DirListBox) Lista de directorios

(FileListBox) Lista de archivos

(Shape) Figura

(Line) Línea

(Image) Imagen

(Data) Conexión a origen de datos

(OLE) Contenedor de documentos embebidos compatibles con Object Linking and Embedding

Se pueden agregar todo tipo de controles de terceros, una gran cantidad de ellos de serie con la instalación de Visual Basic 6.0, que vienen embebidos dentro de archivos de extensión *.OCX.

El panel lateral derecho contiene dos vistas principales:

El Explorador de Proyectos, que muestra todos los elementos que componen nuestro proyecto o grupos de proyectos (formularios, interfaz de controles, módulos de código, módulos de clase, etc...)

El Panel de propiedades, donde se muestran todos los atributos de los controles de nuestros formularios o la información de modulos clase y formularios entre otros muchos.

La Ventana de inmediato (por defecto en la parte inferior aunque puede no estar visible. Utilizar Ctrl+G para mostrar la ventana). Esta ventana resulta una herramienta muy útil a la hora de depurar código o incluso de hacer pruebas rápidas, ya que permite imprimir mensajes de texto desde nuestro código y ejecutar sentencias simples de código (solo sentencias que se puedan representar en una sola línea, no permite bloques) que puede ser desde código de nuestra propia aplicación, por ejemplo consultar el valor de una variable o llamar a un método declarado en el módulo que se está depurando, así como ejecutar código al vuelo, esto viene a ser por ejemplo probar cosas como:?2+2

Al ejecutarlo devolvería el resultado de la operación, pudiendo usar variables del código de la aplicación, o sentencias de código como:

Msgbox "Prueba de cuadro de mensaje de error.", vbCritical, "Titulo del mensaje"

A la hora de depurar errores es útil para consultar el error en cuestión:?Err.Number

Las versiones de Visual Basic para Windows son muy conocidas, pero existe una versión de Microsoft Visual Basic 1.0 para MS-DOS (ediciones Profesional y Estándar) menos difundida y que data de 1992. Era un entorno que, aunque en modo texto, incluía un diseñador de formularios en el que se podían arrastrar y soltar distintos controles.

La última versión sólo para 16 bits, la 3.0, no incluía una detallada biblioteca de componentes para toda clase de usos. Durante la transición de Windows 3.11 a Windows 95, apareció la versión 4.0, que podía generar programas de 16 y 32 bits a partir de un mismo código fuente, a costa de un gran aumento en el tamaño de los archivos "runtime" necesarios. Además, se sustituyen los controles VBX por los nuevos OCX. Con la versión 5.0, estuvo a punto de implementar por primera vez la posibilidad de compilar a código nativo, obteniendo una mejora de rendimiento considerable. Tanto esta como la posterior 6.0 soportaban características propias de los lenguajes orientados a objetos, aunque careciendo de algunos ítems importantes como la herencia y la sobrecarga. La versión 6.0 continua utilizándose masivamente y es casi compatible prácticamente al 100% con las últimas versiones de Windows como Vista y Windows 7.

Las versiones actuales de Visual Basic se basan en la plataforma .NET, que se desligan de las anteriores versiones.

Cabe mencionar que aunque menos conocido, existió también una versión gratuita de Visual Basic 5.0 dedicada en su práctica al desarrollo de controles y componentes, su nombre en concreto era Microsoft Visual Basic 5.0 Control Creation Edition (Visual Basic 5 CCE). También hubo versiones orientadas al desarrollo de aplicaciones para dispositivos móviles basados en Windows CE y Pocket PC, conocido como eMbedded Visual Basic.

Características de Visual Basic

Barra de titulo: muestra el nombre del proyecto y del formulario q se está diseñando actualmente

Barra de menús: agrupa los menús despegables que contienes todas las operaciones que pueden llevarse a cabo con Visual Basic 6.0.

Barra de herramientas estándar: contienen los botones que se utilizan con mayor frecuencia cuando se trabaja con un proyecto. Simplifica la elección de opciones de los menús Archivo, Edición, Ver y Ejecutar; además, en el área derecha presenta la ubicación (coordenadas) y el tamaño del objeto seleccionado

Ventana de formulario: es el área donde se diseña la interfaz gráfica, es decir, es donde se inserta electo gráficos, como botones, imágenes, casilla de verificación, cuadros de listas, etc.

Cuadro de herramientas: presenta todos los controles necesarios para diseñar una aplicación, como cuadros de texto, etiquetas, cuadros de listas, botones de comandos, etc.

Ventana de proyecto: muestra los elementos involucrados en el proyecto, como formularios, módulos, controles oxc, etc. Cada elemento puede seleccionarse en forma independiente para su edición.

Ventana de posición del formulario: muestra la ubicación que tendrá el formulario en la pantalla, cuando ejecute la aplicación. Esta ubicación puede cambiarse si se hace clic con el botón izquierdo del mouse.

La Ventana propiedades muestra todas las propiedades del control actualmente seleccionado, en este caso muestra las propiedades del Form1, luego podemos ver que abajo dice "Form1 Form", lo que está en negrita es el nombre del objeto, y lo que le sigue es el tipo de objeto, en este caso es un Formulario (Form)